Jetson Nano: Künstliche Intelligenz für die Massen

472 GFLOPS für 99 US-Dollar: Nvidias neue CUDA-X-Computing-Plattform Jetson Nano soll die Einstiegshürden für KI-Projekte drastisch nach unten verschieben. Das Produkt spricht das Millionenheer an Makern und Technologiefans an – aber auch professionelle Embedded Designer etwa in Start-Ups.

Anbieter zum Thema

Nvidia hat seine KI-Plattform Jetson um ein Modul samt passendem Entwicklungs-Kit nach unten erweitert: Jetson Nano spricht Tüftler, Technologiefans und Embedded-Designer an, die für ihre KI-Projekte eine günstige und trotzdem leistungsfähige Plattform suchen. „Mit Nano steigt die Reichweite unserer Jetson-Plattform auf rund 30 Millionen Hersteller, Entwickler, Erfinder und Studenten weltweit“, sagt Deepu Talla, Vice President und General Manager of Autonomous Machines von Nvidia, bei der Vorstellung der neuen Plattform zur GPU Technology Conference.

Laut Nvidia ist das jüngste Mitglied der Jetson-Familie, zu der auch die Modelle Jetson AGX Xavier für vollautonome Maschinen und Jetson TX1/TX2 für KI-Processing am Edge gehören, softwarekompatibel mit allen anderen CUDA-X-basierten Produkten. Jetson Nano ist in zwei Versionen erhältlich: als Entwickler-Kit für 99 US-Dollar oder als „production-ready“-System-on-Modul für 129 US-Dollar. Letzteres wird voraussichtlich ab Juni 2019 in den Handel kommen.

Jetson Nano verfügt über eine Quad-Core 64-Bit-ARM-A57-CPU und einen integrierten 128-Core-Grafikprozessor (Graphic Processing Unit, GPU) mit Maxwell-Architektur. In Kombination mit 4 GB 64-Bit-LPDDR4-Speicher erreicht das Modul 472 GFLOPS Rechenleistung. Als Speicherdurchsatz gibt der Hersteller 25,6 GBit/s an. Damit ist Nano deutlich performanter als typische Maker-Boards auf Raspberry-Pi- oder Arduino-Basis. Trotzdem verbraucht das Modul je nach aktiviertem Leistungsmodus lediglich zwischen 5 W und 10 W.

Softwarekompatibel mit größeren Systemen

Laut Nvidia basiert Jetson Nano auf der hauseigenen CUDA-X-Technologie. Die „Computer Unified Device Architecture“ ist in der Lage, einzelne Programmteile auf die GPU auszulagern und so den Hauptprozessor zu entlasten. Zudem ist die GPU viel besser für das massenhafte parallele Verarbeiten bestimmter Routinen geeignet. Das beschleunigt die Verarbeitung neuronaler Netze erheblich. Der Clou sei jedoch die Softwarekompatibilität: Laut Talla laufen auf der Nano-Plattform sämtliche Modelle, die ursprünglich für andere auf CUDA-X basierende Plattformen geschrieben.

„Jetson Nano unterstützt hochauflösende Sensoren, kann mehrere Sensorfunktionen parallel bearbeiten, und zudem auf jeden Sensor-Datenstrom mehrere neuronale Netze anwenden“, sagt Talla bei der Einführung der neuen Plattform zur GPU Technology Conference. Darüber hinaus unterstütze Jetson Nano mehrere populäre KI-Frameworks. Entwickler sollen dadurch schnell ihre bevorzugten KI-Modelle und -Frameworks in das Produkt integrieren können.

Vollständige Desktop-Linux-Umgebung enthalten

Das ebenfalls neu veröffentlichte JetPack 4.2 SDK ist ein kompletter KI-Software-Stack mit beschleunigten Bibliotheken für Deep Learning, Computer Vision, Computer Graphics und Multimedia Processing, der die gesamte Jetson-Familie unterstützt. Enthalten ist eine vollständige Desktop-Linux-Umgebung (Linux for Tegra) basierend auf Ubuntu 18.04 mit beschleunigter Grafik, Unterstützung für NVIDIA CUDA Toolkit 10.0 und Bibliotheken wie cuDNNN 7.3 und TensorRT 5. Das SDK bietet zudem die Möglichkeit, beliebte Open-Source-Machine-Learning-(ML)-Frameworks wie TensorFlow, PyTorch, Caffe, Keras und MXNet sowie Frameworks für die Entwicklung von Computer Vision und Robotik wie OpenCV und ROS zu installieren.

Die vollständige Kompatibilität mit diesen Frameworks soll Entwicklern das Bereitstellen KI-basierter Inferenz-Workloads für Jetson erheblich erleichtern. Jetson Nano ermöglicht Echtzeit-Computer-Vision und Inferencing für viele komplexe „Deep Neural Network“-(DNN)-Modelle. Damit lassen sich zum Beispiel multisensorische autonome Roboter und IoT-Geräte mit intelligentem Edge-Processing realisieren. Mithilfe von ML-Frameworks soll es zudem möglich sein, neuronale Netze direkt auf dem Jetson Nano weiter zu trainieren.

Anschlussfreundiges Entwickler-Kit

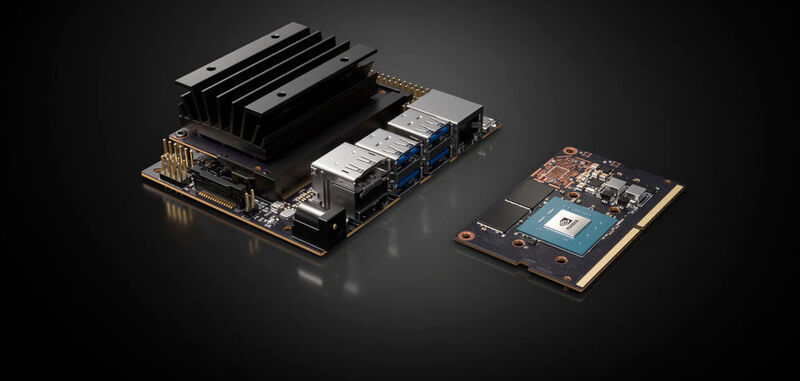

Das Entwickler-Kit hat eine Grundfläche von nur 80 mm x 100 mm und lässt sich per Micro-USB oder einen 5V-DC-Buchsenadapter mit Strom versorgen. Als Boot-Medium nutzt das Entwickler-Kit eine MicroSD-Karte. An Bord befinden sich vier Hochgeschwindigkeits-USB 3.0-Ports, MIPI CSI-2-Kamerastecker, HDMI 2.0 und DisplayPort 1.3, Gigabit Ethernet, ein M.2-Key-E-Modul, MicroSD-Kartensteckplatz und ein 40-poliger GPIO-Stecker. „Die Anschlüsse arbeiten sofort mit vielen beliebten Peripheriegeräten und Sensoren zusammen“, sagt Talla. So ließen sich direkt Projekte wie der 3D-druckbare Deep-Learning-JetBot umsetzen, den Nvidia auf GitHub als Open-Source zur Verfügung stellt.

Der Kamerastecker auf der Platine ist kompatibel mit preiswerten MIPI CSI-Sensoren. Dazu zählen laut Nvidia auch Module, die auf dem 8-MP-IMX219 basieren und von Jetson-Ökosystempartnern erhältlich sind. Ebenfalls unterstützt Jetson Nano demnach das Raspberry Pi Camera Module v2, die Treiberunterstützung dafür ist im JetPack enthalten.

Jetson Nano Module: System-on-Module für KI-Processing

Kern des Kits ist das System-on-Module (SoM), auf dem das System-on-a-Chip (SoC) neben 16 GB eMMC-Onboard-Speicher und dem Energiemanagement untergebracht sind. Es gleicht einem SO-DIMM mit 260-poligem Anschluss. Das Jetson Nano-Compute-Modul misst lediglich 45 mm x 70 mm und nutzt das Unified-Memory-Subsystem von Nvidia. CPU, GPU und Multimedia-Engines können darüber gemeinsam auf den Speicher zugreifen. Nvidia will es ab Juni 2019 für 129 US-Dollar (ab 1000 Stück) für Embedded-Designer zur Integration in Produktionssysteme ausliefern.

Neben PCIe, MIPI DSI, weiteren GPIO stehen zwölf Lanes MIPI CSI-2 zum Anschluss von bis zu drei x4-Kameras oder bis zu vier Kameras in x4/x2-Konfigurationen zur Verfügung. So gerüstet soll es bis zu acht HD-Videoströme in Echtzeit verarbeiten können. Dank seines geringen Stromverbrauchs eignet sich das Produkt nach Angaben des Herstellers unter anderem als intelligente Videoanalyseplattform für Netzwerk-Videorekorder (NVR), Smart Kameras und IoT-Gateways.

Laut Nvidia kann Jetson Nano viele KI-Netzwerke ausführen, zum Beispiel ML-Frameworks wie TensorFlow, PyTorch, Caffe/Caffe2, Keras, MXNet. Durch das Integrieren von Funktionen wie Bilderkennung, Objekterkennung und -lokalisierung, Posenabschätzung, semantische Segmentierung, Video-Optimierung und intelligente Analytik sollen sich beispielsweise autonome Maschinen und komplexe KI-Systeme aufbauen lassen.

:quality(80)/images.vogel.de/vogelonline/bdb/1498900/1498909/original.jpg)

Embedded-Plattform bietet 32 TeraOps für den Einsatz von KI in der Robotik

:quality(80)/images.vogel.de/vogelonline/bdb/1528900/1528977/original.jpg)

45 Betriebssysteme für den Raspberry Pi

:quality(80)/images.vogel.de/vogelonline/bdb/1532000/1532037/original.jpg)

Nvidia kauft Mellanox für 7 Milliarden US-Dollar

(ID:45821773)

:quality(80)/p7i.vogel.de/wcms/a4/d1/a4d112808ba72fb31a6c9770d11ef157/0118199593.jpeg)

:quality(80)/p7i.vogel.de/wcms/ef/72/ef721c7df54421ff4f6b911b9f5826e8/0118218658.jpeg)

:quality(80)/p7i.vogel.de/wcms/ed/b3/edb3872e6b2694039a712ba762bf5ea3/0118168079.jpeg)

:quality(80)/p7i.vogel.de/wcms/42/22/42228875afe426c07bd09726de8ce039/0118250473.jpeg)

:quality(80)/p7i.vogel.de/wcms/d6/10/d6101a2aac8c7d2cab2ff31546979254/0118103063.jpeg)

:quality(80)/p7i.vogel.de/wcms/29/c2/29c2b968dc07be08e6062d8e6d8c387b/0118061450.jpeg)

:quality(80)/p7i.vogel.de/wcms/90/27/9027f3a201ad0e0eeeecc53846e2a990/0118165202.jpeg)

:quality(80)/p7i.vogel.de/wcms/fe/b1/feb1ceb3750245197d7851df67e05479/0118163169.jpeg)

:quality(80)/p7i.vogel.de/wcms/5f/c6/5fc62a91bffb6c673c36722011f8205c/0118076327.jpeg)

:quality(80)/p7i.vogel.de/wcms/1e/51/1e513481ef401300756c3bb189188c01/0117631502.jpeg)

:quality(80)/p7i.vogel.de/wcms/56/6f/566fa0229f2dbf6aa49dfa4923210b21/0118162056.jpeg)

:quality(80)/p7i.vogel.de/wcms/f3/24/f3245522a3428e1787cd2418d901c62c/0118152080.jpeg)

:quality(80)/p7i.vogel.de/wcms/c9/22/c9228b8ec955c03dc075e8875f4cabf8/0117754897.jpeg)

:quality(80)/p7i.vogel.de/wcms/07/6f/076f09c7a697f193091a6e6be846aef1/0117862638.jpeg)

:quality(80)/p7i.vogel.de/wcms/30/51/305138abdaeda721646661bf6ac4fdbd/0117756540.jpeg)

:quality(80)/p7i.vogel.de/wcms/3c/b9/3cb980e98baaaadddf69a5dad4ad20a0/0117334644.jpeg)

:quality(80)/p7i.vogel.de/wcms/79/4b/794b7d23361d39306753a0abab662274/0117836261.jpeg)

:quality(80)/p7i.vogel.de/wcms/f3/88/f388bad02124a8ac7fc5663627838b69/0117819459.jpeg)

:quality(80)/p7i.vogel.de/wcms/2b/cc/2bccc41bb07c895dda4839b927d8c265/0116514416.jpeg)

:quality(80)/p7i.vogel.de/wcms/36/94/36944586a51513ee0dc4cbb1fa410689/0118252602.jpeg)

:quality(80)/p7i.vogel.de/wcms/1e/5a/1e5a931b4b81371d6761358130476db5/0117914243.jpeg)

:quality(80)/p7i.vogel.de/wcms/f7/a8/f7a8de2339926d03f6309495bb3e3cdf/0117808261.jpeg)

:quality(80)/p7i.vogel.de/wcms/18/32/1832350986a019c0f74079c2fd03fa28/0117909885.jpeg)

:quality(80)/p7i.vogel.de/wcms/02/39/0239f3ad5b99d9cde1e9a269105dac38/0118236281.jpeg)

:quality(80)/p7i.vogel.de/wcms/bf/75/bf75e96d07c11d7e147b16235159c660/0118153476.jpeg)

:quality(80)/p7i.vogel.de/wcms/d0/15/d01573f5c7986989d4fa27fecdb17c32/0118126305.jpeg)

:quality(80)/p7i.vogel.de/wcms/08/de/08de3cefb97266232f475bb011d9b0c6/0118162151.jpeg)

:quality(80)/p7i.vogel.de/wcms/a2/24/a2249bc111c69b9af5404fc356834e9b/0118129754.jpeg)

:quality(80)/p7i.vogel.de/wcms/16/cc/16cc54cea371a36ebef7a53b952f8516/0118069700.jpeg)

:quality(80)/p7i.vogel.de/wcms/15/74/15744e690ff03eef2b863223b28604fd/0118160633.jpeg)

:quality(80)/p7i.vogel.de/wcms/0f/63/0f6307f7514bc193712954c50b80f0f7/0118163432.jpeg)

:quality(80)/p7i.vogel.de/wcms/7d/41/7d4118afaafc06500e8f54ebf6079493/0118116849.jpeg)

:quality(80)/p7i.vogel.de/wcms/c2/66/c266c5cfbc51fb7d06557ee079d406bf/0116839110.jpeg)

:quality(80)/p7i.vogel.de/wcms/3a/1a/3a1a267224e51b795ccc6b8df959f18e/0115998041.jpeg)

:quality(80)/p7i.vogel.de/wcms/3d/14/3d1447535880e284712d1daba8d7d466/0115848899.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/5e/e8/5ee8685f55961/duagon-logo-without-r.png)

:fill(fff,0)/p7i.vogel.de/companies/65/f1/65f186172d9f0/syslogic-logotype-alt-navy-mint.jpeg)

:fill(fff,0)/images.vogel.de/vogelonline/companyimg/133900/133981/65.png)

:quality(80)/images.vogel.de/vogelonline/bdb/1538400/1538432/original.jpg)

:quality(80)/images.vogel.de/vogelonline/bdb/1538400/1538437/original.jpg)

:quality(80)/p7i.vogel.de/wcms/e5/af/e5afe34b00e1d0573d69cec4bfbfc3d7/0111219649.jpeg)

:quality(80)/p7i.vogel.de/wcms/bd/d7/bdd7ca4ca47332cb37a1b3d9f38d7cc2/0114179281.jpeg)